Stammdaten von hoher Qualität sind eine wichtige Voraussetzung dafür, dass ein Unternehmen seine strategischen Herausforderungen bewältigen kann. Zudem ist es einfacher, behördliche und gesetzliche Auflagen zu erfüllen, wenn die Stammdaten gepflegt sind. Und auch die Harmonisierung, Integration und Standardisierung von Geschäftsprozessen erfordern eine qualitativ hochwertige Datenbasis.

Migrationsprojekte sensibilisieren Unternehmen für die Bedeutung einer hohen Datenqualität, da sie in der Regel auch eine Datenbereinigung beinhalten. Je länger das neue System dann allerdings im Einsatz ist, desto häufiger schleichen sich gewisse Unzulänglichkeiten und Ungenauigkeiten bei der Datenpflege ein. Das Resultat: Die Qualität sinkt kontinuierlich.

Unternehmen sollten daher eine Strategie entwickeln, wie sie die Qualität ihrer Stammdaten, die sie im Rahmen einer Migration schaffen, wirkungsvoll überwachen und dauerhaft aufrechterhalten können. Diese Strategie kann beispielsweise Maßnahmen umfassen, um Dubletten zu vermeiden, die Adressen aktuell zu halten, richtige Feldformate zu validieren oder das vorhandene Datenmaterial anzureichern und zu ergänzen.

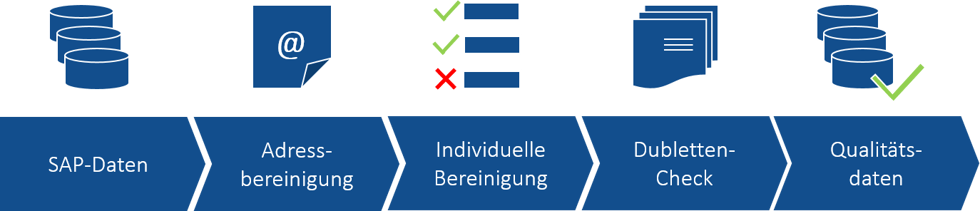

Die Phasen einer Datenmigration im Überblick

-

Phase 4: Überwachung der Datenqualität

Regeln für Qualität festlegen

Um überhaupt beurteilen zu können, wann Daten eine hohe Qualität aufweisen, gilt es zunächst, entsprechende Regelwerke für die Qualitätssicherung zu definieren und ihre Einhaltung im Live-Betrieb zu überwachen. Dabei kann eine Data Quality Scorecard helfen, die Auskunft darüber gibt, inwieweit die Unternehmensdaten die analytischen und operativen Prozesse unterstützen. Bestandteile von Regelwerken zur Datenqualität können folgende Fragen sein:

-

Weisen die Telefonnummern ein einheitliches Format auf?

-

Haben die E-Mail-Adressen das korrekte Format?

-

Sind die Bankverbindungen korrekt erfasst?

-

Wann gilt ein Datensatz als Dublette?

-

Ist die EAN gepflegt? Sind die Produktbeschreibungen korrekt?

-

Sind die Adressdaten aktuell?

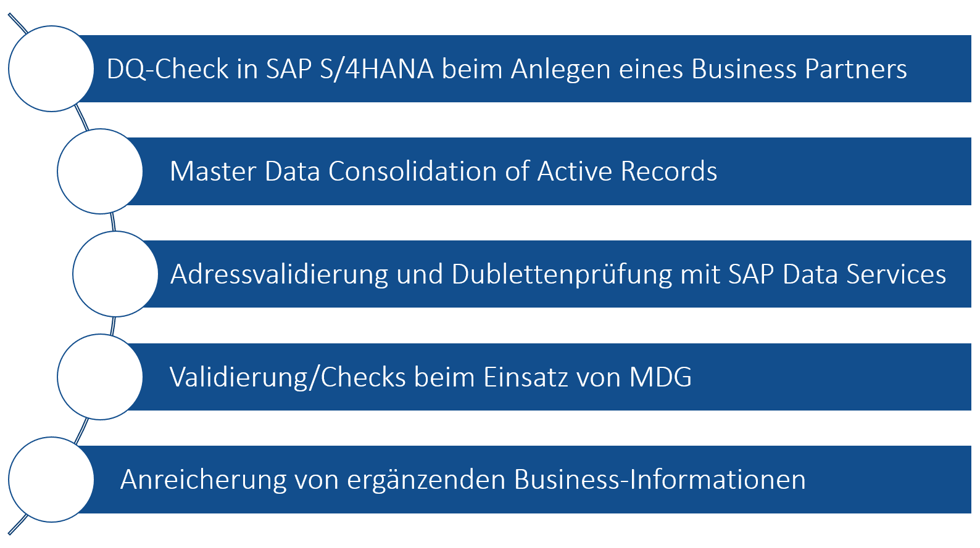

Daran anknüpfend möchten wir noch einen kurzen Blick auf die wichtigsten Validierungsszenarien werfen. Schon beim Anlegen eines Business Partners in SAP S/4HANA gibt es die Möglichkeit, einen Data-Quality-Check durchzuführen. Dabei wird geprüft, ob Dubletten vorhanden und alle erforderlichen Felder befüllt sind. Das Tool „Master Data Consolidation of Active Records“ untersucht den Datenbestand hinsichtlich Dubletten und der Frage, ob sich ein Master Data Record bilden lässt. Auch mit SAP Data Services lassen sich verschiedene Adressvalidierungen und Dublettenprüfungen durchführen. Hierfür sind allerdings lizenzpflichtige Data-Quality-Funktionalitäten erforderlich. Ein weiteres Tool für Datenvalidierungen und -checks ist SAP Master Data Governance (SAP MDG). Und auch die Anreicherung und Vervollständigung eines Datensatzes mit ergänzenden Business-Informationen wirkt sich positiv auf die Datenqualität aus.

Verschiedene Validierungsszenarien in der Übersicht

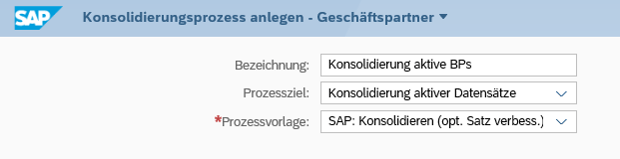

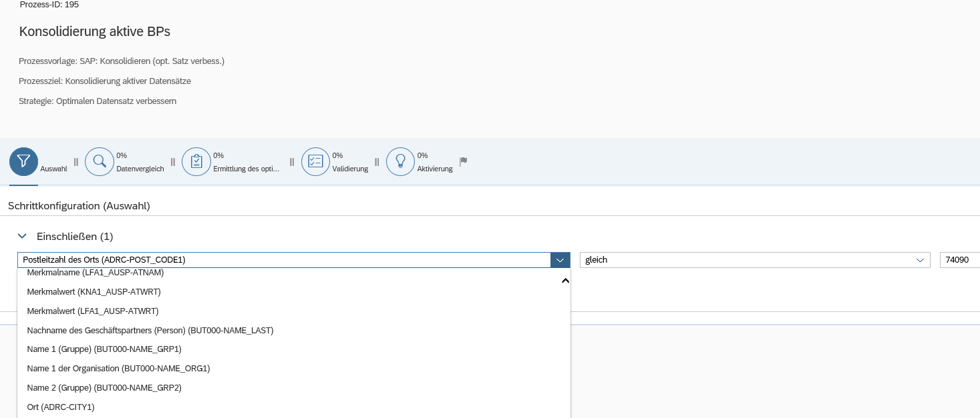

Master Data Consolidation of Active Records

Das Tool konsolidiert die aktiven Daten im System und ermittelt den optimalen Datensatz (Master Data Record) gemäß definierter Regeln sowie der Ergänzung zusätzlicher Informationen aus den Dubletten. Es lassen sich verschiedene Prozessstrategien für Dubletten anwenden:

-

Dubletten entfernen (Vormerken der Dubletten zur Löschung, Lenken des Key Mapping auf den optimalen Datensatz)

-

Optimalen Datensatz verbessern (Beibehalten der Dubletten, keine Veränderung des Key Mapping)

-

Alle Datensätze verbessern (gleiche Informationstiefe und -fülle der Datensätze, Beibehalten der Dubletten, keine Veränderung des Key Mapping)

Was den Ablauf des Prozesses betrifft, muss zunächst das Master Data Object ausgewählt werden, das auf Dubletten geprüft werden soll. Auf Basis der vorhandenen Konfiguration ermittelt das Tool die Matching-Ergebnisse. Anschließend werden die ermittelten Best Records überprüft und die Datensätze auf Grundlage der definierten Regeln validiert. Abschließend erfolgt die Aktivierung der Ergebnisse in der Datenbank.

Nach Ermittlung des Best Record werden alle Datensätze auf ihn konsolidiert. Business-Partner-Dubletten werden durch den Best Record ersetzt. Es kommt zur Aktualisierung des Key Mapping, wobei auch die Bewegungsdaten auf den richtigen Datensatz konsolidiert werden. Optional ist das Setzen von Sperrkennzeichen für die Duplikate in der Dublettengruppe möglich.

Adressvalidierung und Dublettenprüfung mit SAP Data Services

Nachdem der Anwender die Tabellen in SAP Data Services geladen hat, erfolgt zunächst eine Adressbereinigung, gefolgt von einer individuellen Bereinigung, die gefundene Fehler korrigiert. Mithilfe von postalischen Verzeichnissen prüft das System die Adressen und ergänzt fehlende Postangaben. Darüber hinaus nimmt es eine Standardisierung der Adresszeilen vor. Ein aussagekräftiges Protokoll fasst die Ergebnisse der Bereinigung und die Qualität der Adressen zusammen. Bei Bedarf kann der Fachbereich noch eine individuelle Nachbearbeitung der Daten vornehmen. Anschließend werden die geprüften Datensätze wieder in das SAP S/4HANA-System geladen.

Für die Dublettenprüfung erfolgt entweder ein direkter Zugriff auf die relevanten Tabellen in SAP S/4HANA oder es werden die im Vorfeld per Adress-Cleansing bereits bereinigten Adressdatensätze verwendet. Die Methode der Dublettenprüfung kann individuell festgelegt werden. Fuzzy-Matching-Methoden decken schwer zu erkennende Dubletten auf, die aus Rechtschreib- und Tippfehlern sowie unterschiedlichen Formatierungen resultieren. Nach der Prüfung hält ein Protokoll den Qualitätsgrad der Daten fest. Die Definition des Golden Record kann automatisiert oder durch den Fachbereich erfolgen, der festlegt, ob es sich um eine Dublette handelt. Nach der Dublettenprüfung liegen Qualitätsdaten vor, die zurück in die SAP-Tabellen geladen werden.

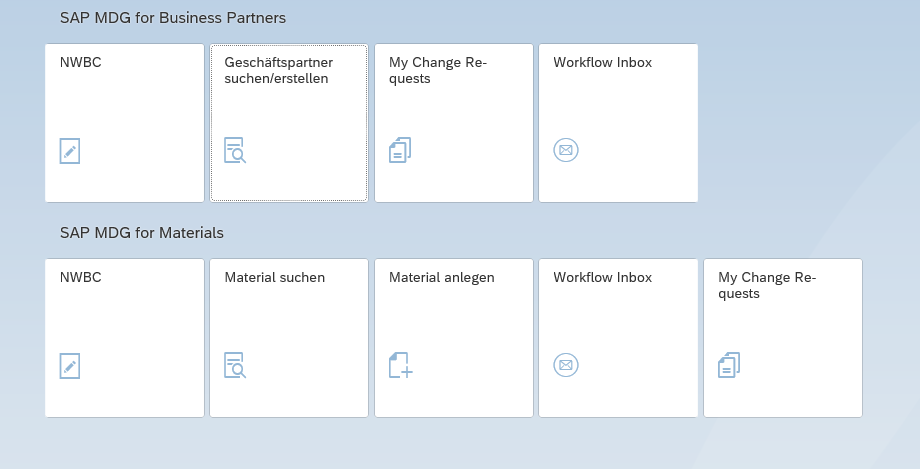

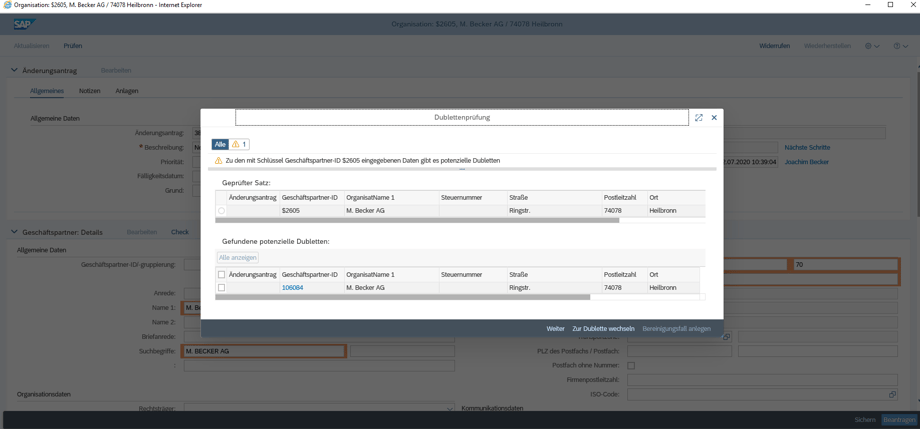

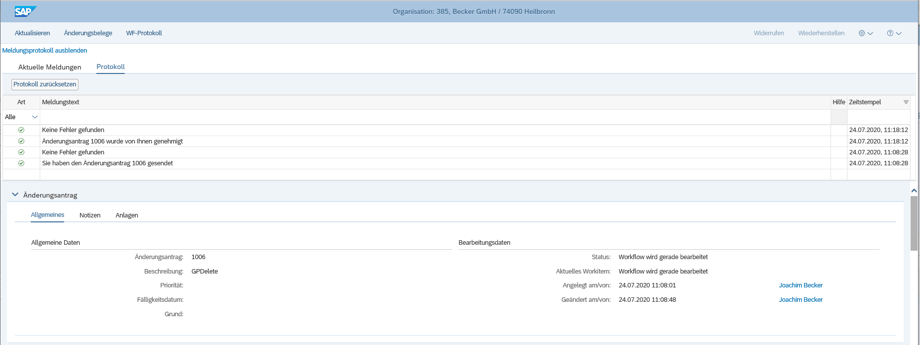

Validierung/Checks beim Einsatz von SAP MDG

Ein wesentlicher Vorteil von SAP MDG liegt in der Einführung einer zentralen Ownership aller Stammdaten. Das bedeutet, dass eine Stelle darüber entscheidet, ob Veränderungen im Bestand vorgenommen werden oder nicht. Das Bearbeiten von Stammdaten funktioniert auf der Basis von Änderungsanträgen. Das flexible Workflow-Konzept ermöglicht einen individuellen Prozess zur Steuerung der Stammdaten einschließlich Qualitätsprüfung und Berechtigungen, der zu den Anforderungen des jeweiligen Unternehmens passt. Um die Qualität der Stammdaten zu erhöhen, lassen sich in BRF+ eigene Regeln definieren oder externe Services für die Datenqualitätsprüfung verwenden.

Anreicherung/Validierung von zusätzlichen Informationen

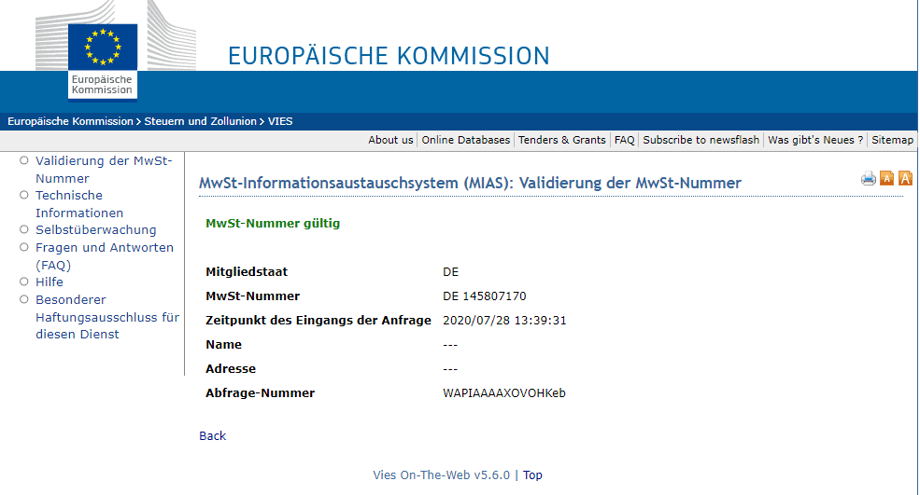

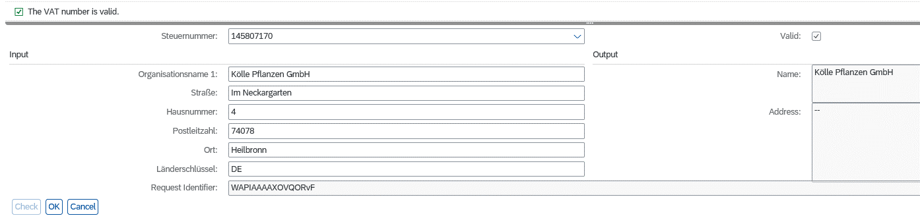

Hierbei ist das Ziel, die Datenqualität ohne großen manuellen Aufwand zu steigern. Bei vielen Business-Informationen – Adress-, Geo-, Telekommunikationsdaten, Branchen- und Produktinformationen – können Unternehmen externe Angebote nutzen. Für die Validierung und Anreicherung von Adressdaten lassen sich beispielsweise die bekannten Kartenanbieter (Google Maps, Here) nutzen. Anhand von Business-Verzeichnissen wie Dun & Bradstreet oder CDQ werden Detailinformationen (HR-, Steuerinformationen, Telekommunikationsdaten) ergänzt. Um Umsatzsteuer-Identifikationsnummern (USt-IdNr.) zu validieren, bietet die EU den VIES-Service. Zusätzlich kann geprüft werden, ob bei einer USt-IdNr. auch die korrekten Firmeninformationen hinterlegt sind.

Fazit: Lohnender Aufwand

Unabhängig von der genauen Methode, die Unternehmen für ihre Datenprüfungen einsetzen, ist das Herbeiführen einer hohen Datenqualität und ihre anschließende Aufrechterhaltung immer mit einem gewissen Aufwand verbunden. Letztlich sind es aber lohnende Anstrengungen, da Unternehmen im Tagesgeschäft in hohem Maße von bereinigten und konsistenten Datenbeständen profitieren. Idealerweise sollte die Datenqualität daher nicht nur bei anstehenden Systemmigrationen im Fokus stehen, sondern dauerhaft einen entsprechenden Stellenwert im Unternehmen genießen. Wer die notwendigen Prozesse implementiert, um seine Datenbestände regelmäßig auf Aktualität und Richtigkeit zu prüfen, wirkt einer schleichenden Abnahme der Datenqualität effektiv entgegen.

![IBacademy_Logo_blau[496] IBacademy_Logo_blau[496]](https://www.ibsolution.com/hs-fs/hubfs/IBacademy_Logo_blau%5B496%5D.jpg?width=200&name=IBacademy_Logo_blau%5B496%5D.jpg)